声明:本文来源于微信公众号 新智元(ID:AI_era),作者:新智元,授权站长之家转载发布。

【新智元导读】谷歌全新视频生成模型VideoPoet再次引领世界!10秒超长视频生成效果碾压Gen-2,音频生成和风格转换也可以进行。

AI视频的生成可能是2024年的最前沿(juan)的领域。

回顾过去几个月,RunWayGen-2、Pika Lab的Pika1.0、国内大厂等大波视频生成模型纷纷涌现,不断迭代升级。

不,RunWay一大早就宣布Gen-2支持文本转语音的功能,可以为视频创建画外音。

当然,谷歌也不愿意在视频生成上落后。首先,它与斯坦福大学的李飞飞团队联合发布了W.A.L.T,由Transformer制作的逼真视频引起了极大的关注。

今天,谷歌团队发布了一个全新的视频生成模型VideoPoet,可以在没有特定数据的情况下生成视频。

论文地址:https://blog.research.google/2023/12/videopoet-large-language-model-for-zero.html

最令人惊讶的是,VideoPoet可以一次生成超长10秒、连贯的大动作视频,完全粉碎Gen-2只有小动作的视频生成。

此外,与领先模型不同,VideoPoet不是基于扩散模型,而是基于多模态大模型,可以拥有T2V、V2A等能力可能成为未来视频生成的主流。

看完后,网友们纷纷「震惊」刷屏。

接下来可以先看一波体验。

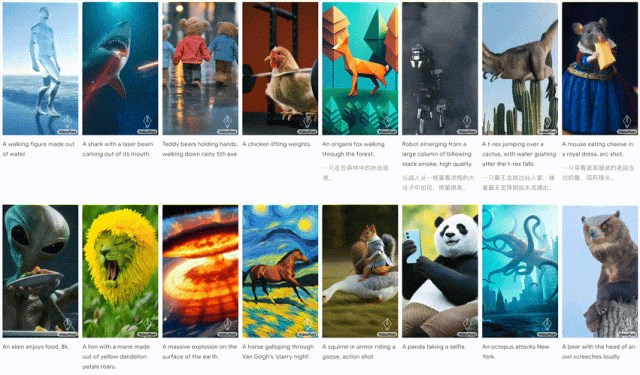

从文本到视频的转换中,生成的视频长度是可变的,并且可以根据文本内容展示各种动作和风格。

例如,熊猫打牌:

Two pandas playing cards

南瓜爆炸:

A pumpkin exploding, slow motion

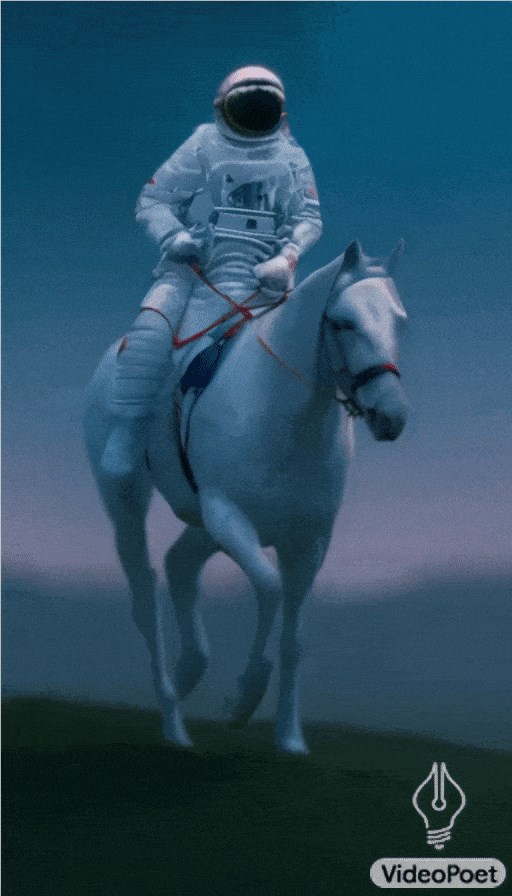

宇航员骑马奔驰:

An astronaut riding a galloping horse

VideoPoet还可以根据给定的提示将输入的图像转换为动画。

左:一艘船在汹涌的海面上航行,周围是雷电场景,以动态油画风格呈现

中间:飞过星云,星云充满闪烁的星星

右:一名拄着手杖的旅行者站在悬崖边,凝视着风中翻腾的海雾

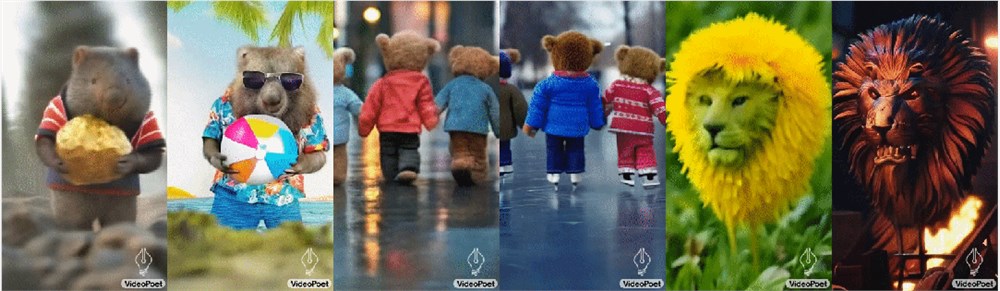

VideoPoet首先预测光流和深度信息,然后将额外的文本输入到模型中。

左:袋熊戴着墨镜,在阳光明媚的海滩上拿着沙滩球

中:泰迪熊在清澈的冰上滑冰

右:一只金属狮子在熔炉的光线下咆哮

从左到右:真实,数字艺术,铅笔艺术,水墨,双重曝光,360度全景,

VideoPoet也可以生成音频。

下面,首先从模型中生成2秒的动画片段,然后尝试在没有任何文本指导的情况下预测音频。这样,视频和音频就可以从一个模型中生成。

VideoPoet通常以纵向的方式生成视频,以便与短片视频的输出一致。

谷歌还专门制作了一部由VideoPoet制作的许多短片组成的短片。

在具体的文本比例安排中,研究人员要求Bard先写一个关于旅行浣熊的短篇故事,并附上一个场景分解和提示列表。然后,为每个提示生成一个视频剪辑,并将所有生成的剪辑拼接在一起,以制作以下最终视频。

视觉上的故事叙述可以通过随时间变化的提示来创造。

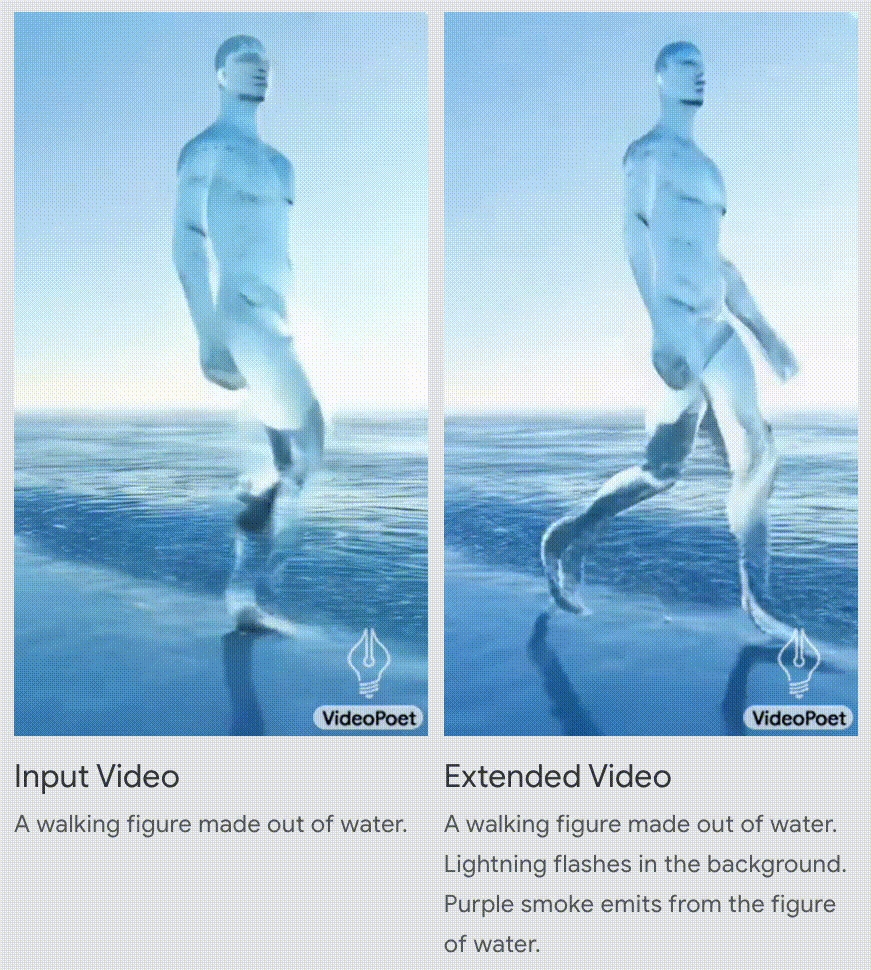

输入:一个由水组成的行走者

扩展:一个由水组成的行走者。背景中有闪电,紫烟从这个人身上散发出来

输入:两只浣熊骑摩托车在松树环绕的山路上行驶,8k

扩展:两只浣熊骑摩托车。流星雨从浣熊身后坠落,撞击地面,引发爆炸。

LLM秒变视频生成器

当前,Gen-2、Pika1.0视频生成的表现令人惊叹,但遗憾的是,在连贯大动作的视频生成中无法表现出惊人的表现。

通常,当它们产生更大的动作时,视频中会出现明显的伪影。

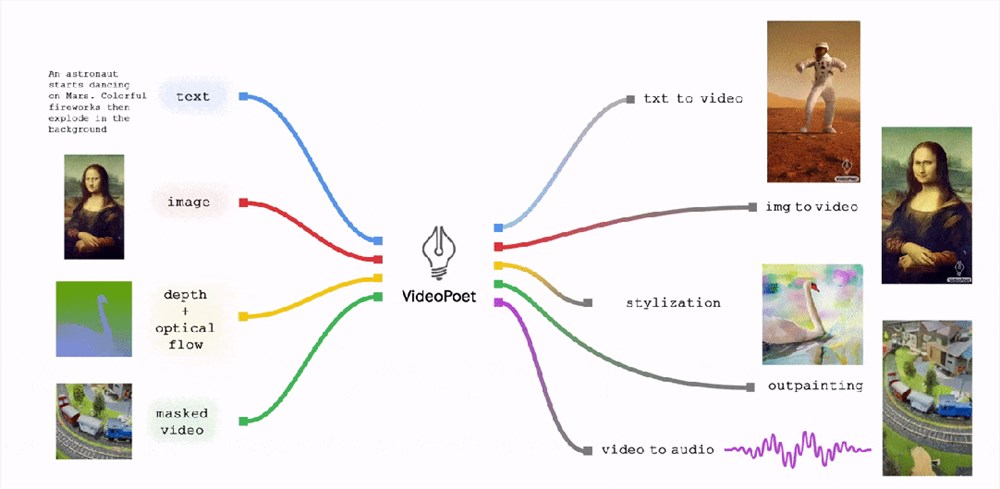

在这方面,谷歌研究人员提出了VideoPoet,可以执行各种视频生成任务,包括文本到视频、图像到视频、视频风格化、视频修复/扩展和视频到音频。

与其他模型相比,谷歌的方法是将各种视频生成功能无缝集成到单一的大语言模型中,而不是依赖为每个任务单独训练的特殊组件。

具体而言,VideoPoet主要包括以下组件:

- MAGVIT预训练 V2视频tokenizer和soundstream音频tokenizer可以将不同长度的图像、视频和音频编辑转换为统一词汇表中的离散代码序列。这些代码与文本语言模型兼容,便于与文本等其他模型相结合。

- 自回归语言模型可以在视频、图像、音频和文本之间进行跨模态学习,并通过自回归预测序列中的下一个视频或音频token。

- 在大语言模型培训框架中,引入了文本到视频、文本到图像、图像到视频、视频帧延续、视频修复/扩展、视频风格化、视频到音频等多种模式生成学习目标。此外,这些任务可以相互结合,以实现额外的零样本功能(如文本到音频)。

VideoPOET可以处理各种以视频为中心的输入和输出。其中,LLM可以选择将文本作为输入来指导文本到视频、图像到视频、视频到音频、风格化和扩展任务的生成

LLM训练的一个关键优点是,它可以重用现有LLM训练基础设施中引入的许多可扩展的效率提高。

然而,LLM运行在离散token上,这可能会给视频生成带来挑战。

幸运的是,视频和音频tokenizer可以将视频和音频编辑编码为离散token序列(即整数索引),并将其转换为原始表示。

VideoPoet通过使用多个tokenizer(MAGVIT用于视频和图像)训练一个自回归语言模型 V2,用于音频的SoundStream)跨视频、图像、音频和文本模式学习。

模型一旦根据上下文生成token,就可以使用tokenizer解码器将这些token转换为可查看的表示形式。

Videopoet任务设计:不同的模式通过tokenizer编码器和解码器与token相互转换。每个模式周围都有边界token,token表示要执行的任务类型

三大优势

综上所述,与Gen-2等视频生成模型相比,VideoPoet具有以下三大优势。

VideoPoet可以通过调整视频的最后一秒并预测接下来的一秒来生成更长的视频。

VideoPoet通过反复循环,不仅可以很好地扩展视频,而且可以忠实地保留所有对象的外观,即使在多次迭代中。

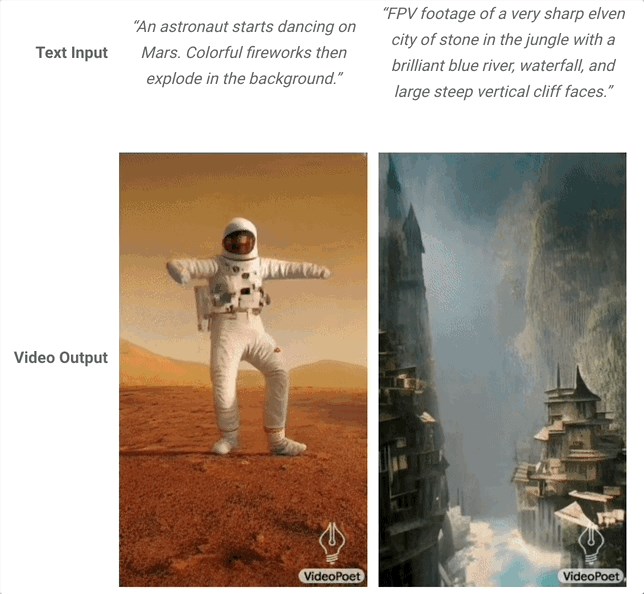

以下是VideoPoet从文本输入生成长视频的两个示例:

左:宇航员在火星上跳舞,背景是五颜六色的烟花

右:无人机拍摄的丛林中有一座非常尖锐的精灵石城,有一条蓝色的河流、瀑布和陡峭的垂直悬崖

与其他只能生成3-4秒视频的模型相比,VideoPoet一次可以生成10秒视频。

无人机拍摄的古堡秋景

视频生成应用程序的一个非常重要的功能是用户对生成的动态效果的控制能力。

这将在很大程度上决定模型是否可以用来制作复杂连贯的长视频。

VideoPoet不仅可以通过文本描述为输入的图像增加动态效果,还可以通过文本提示调整内容,达到预期效果。

左:转身看镜头;右:打哈欠;

视频输入除了支持输入图像的视频编辑外,还可以通过文本精确控制。

对于最左边的浣熊跳舞视频,用户可以用文字描述不同的舞蹈,让它跳不同的舞蹈。

生成「左」:跳机器人舞

生成「中」:跳Gridy舞

生成「右」:一段Frestyle

同样,VideoPoet生成的现有视频片段也可以交互编辑。

如果我们提供输入视频,我们可以改变对象的运动来执行不同的动作。对物体的操作可以第一以帧或中间帧为中心,从而实现高度的编辑控制。

例如,一些片段可以从输入视频中随机生成,然后选择所需的下一个片段。

图中最左边的视频被用作条件反射,在初始提示下生成四个视频:

「一个可爱的破旧蒸汽朋克机器人的特写镜头,上面长满了苔藓和新芽,周围是高高的草」。

对于前三个输出,没有提示动作的独立预测生成。最后一个视频添加到提示中「在烟雾的背景下启动」引导动作产生。

VideoPoet还可以通过在文本提示中添加所需的镜像来准确控制图像的变化。

例如,研究人员通过模型生成图像「冒险游戏概念图,雪山日出,清澈的河流」。下面的例子将给定的文本后缀添加到所需动作中。

从左到右:拉远、滑动变焦、向左移动、弧形运动镜头、摇臂拍摄、无人机航拍

评估结果

最后,VideoPoet在具体实验评估中的表现如何?

谷歌研究人员在各种提示中运行所有模型,以确保评估的客观性,并让人们对其偏好进行评分。

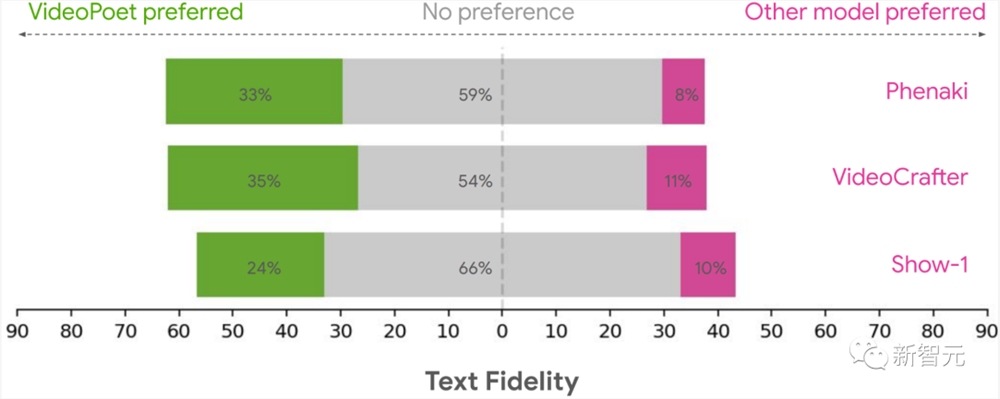

下图显示,VideoPoet在以下问题中被选为绿色首选项目百分比。

文本保真度:

用户对文本保真度的偏好评级,即准确遵循提示首选视频百分比

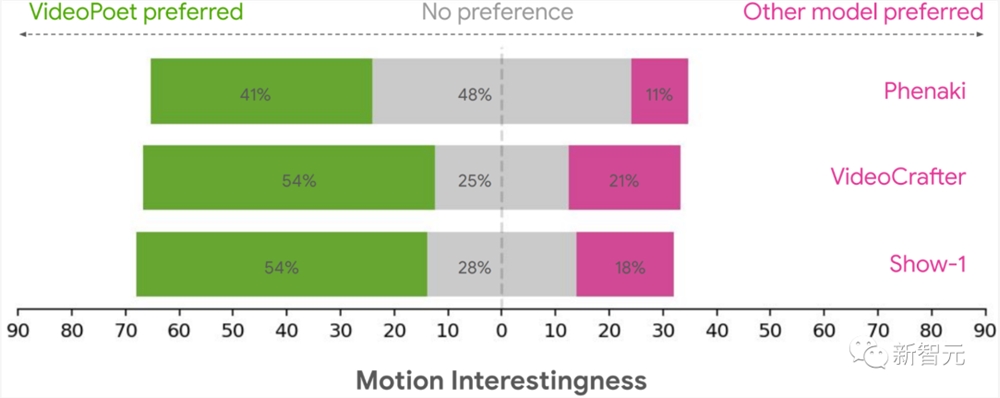

有趣的动作:

在产生有趣的动作时,用户对动作兴趣的偏好评级,首选视频百分比

综上所述,平均24-35%的人认为VideoPoet生成的示例比其他模型更符合提示,而其他模型的比例只有8-11%。

此外,41%-54%的评估师认为VideoPoet中的示例动作更有趣,而其他模型只有11%-21%。

对于未来的研究方向,谷歌研究人员表示,VideoPoet框架将会实现「any-to-any」生成,如将文本扩展到音频、音频到视频、视频字幕等。

网友们不禁要问,Runway和Pika能否抵挡谷歌和OpenAI即将推出的文本到视频创新技术?

参考资料:

https://sites.research.google/videopoet/

https://blog.research.google/2023/12/videopoet-large-language-model-for-zero.html

Copyright © 2013-2025 bacaiyun.com. All Rights Reserved. 八彩云 版权所有 八彩云(北京)网络科技有限公司 京ICP备2023023517号

本站文章全部采集于互联网,如涉及版权问题请联系我们删除.联系QQ:888798,本站域名代理为阿里云