声明:本文来源于微信公众号 量子位(ID:QbitAI),作者:金磊,授权站长之家转载发布。

战国时期2300多年的阅读上古竹简,人工智能正在立功。

而且,这背后的“大功臣”只有2B大小的多模态大模型!

清华大学于2008年7月收藏了这批古竹简,因此也被称为清华简。

清华简的数量约为2500枚,其内容也在先秦竹简中被发现前所未见,它被认为是继甲骨文、敦煌遗书、居延汉简、云梦秦简之后的又一重要发现。

但也正因为如此,识读清华简因为上面的文字基本都是老大难的问题,所以成了老大难的问题。楚文字,统一文字后,秦始皇已被废弃。

最近,在一个2B大小的多模态大模型的帮助下,研究人员在清华简的帮助下成功了。版式检测和文字识别取得突破:

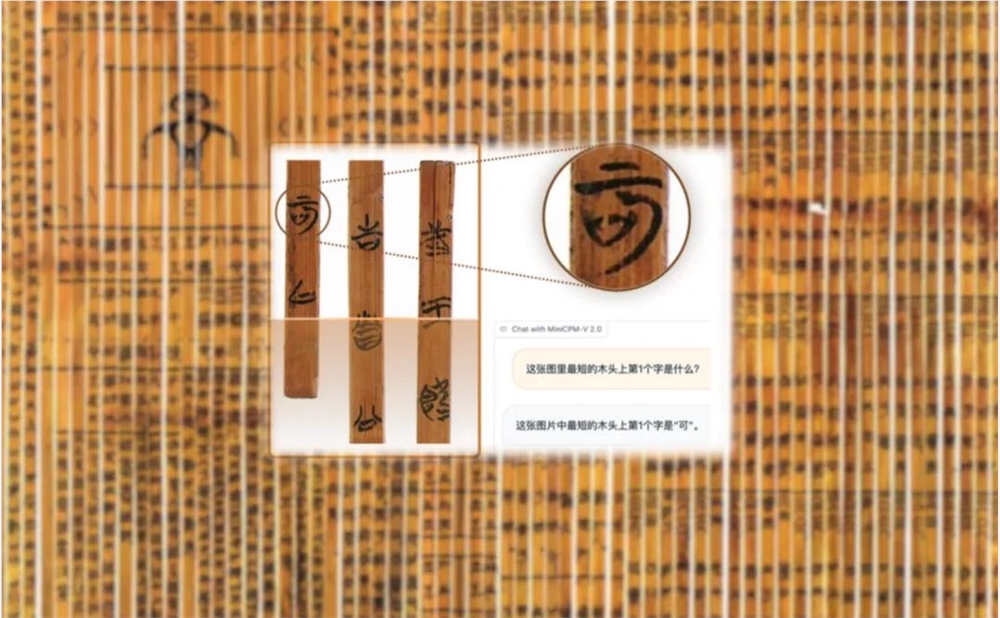

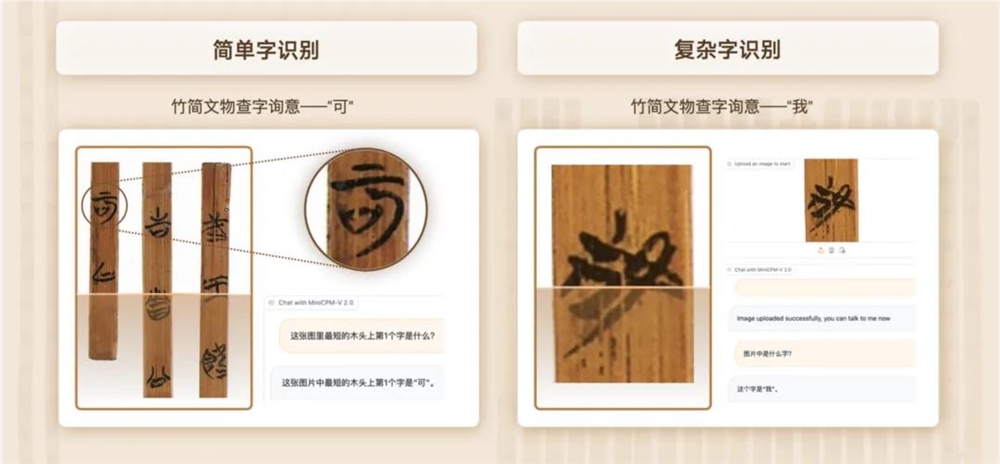

举例来说,询问这个大模型:

这张照片中最短的木头第一什么是个字?

它不仅能准确地找到最短的竹简,还能准确地识别上面的楚文字是现代的“可”字。

即使是与现代文字有很大区别的古代文字,这个大模型也可以查询文字,得出正确的结论“我”。

研究小组还表示,他们正试图继续以这种方式进一步探索。

嗯,我不得不说,大模型“以小博大”这件事已经开始影响多模态。

那么这个2B大模型的来源是什么呢?

不卖关子。

这个2B多模式的大模型是清华初创公司面壁智能最新升级的小钢炮系列,最强端侧多模态大模型——MiniCPM-V2.0。

划个重点:可以用手机跑!

MiniCPM-V2.0的地址:

https://github.com/OpenBMB/MiniCPM-V

MiniCPM系列地址:

https://github.com/OpenBMB/MiniCPM

那么它的能力是什么呢?为什么是这样?最强端侧多模态大模型

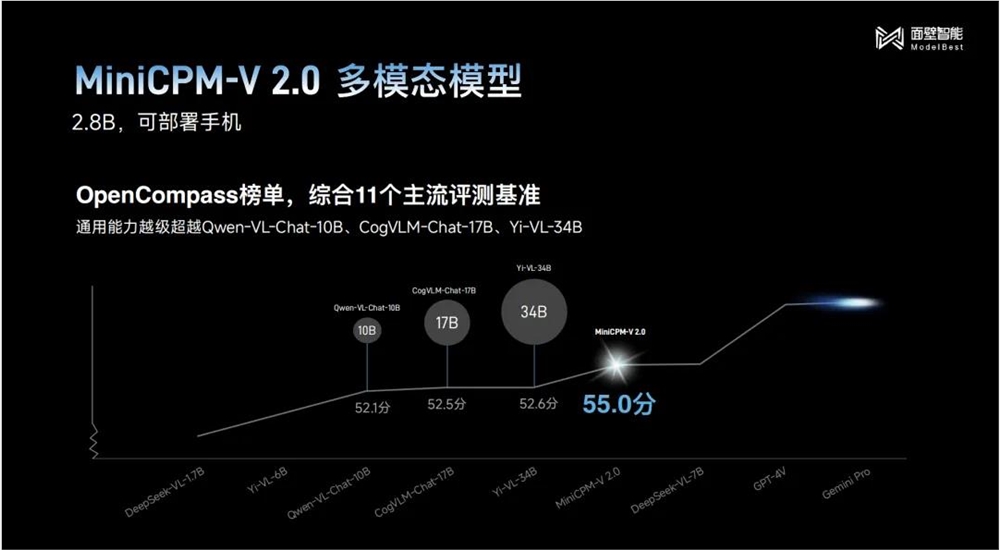

首先来看多模态通用能力,这也是衡量底座水平的重要指标。

多模态大模型综合评价权威测试结果显示在平台OpenCompass列表中,MiniCPM-V2.0虽然体积只有2B,但得分已经超过10B、主流选手17B甚至34B:

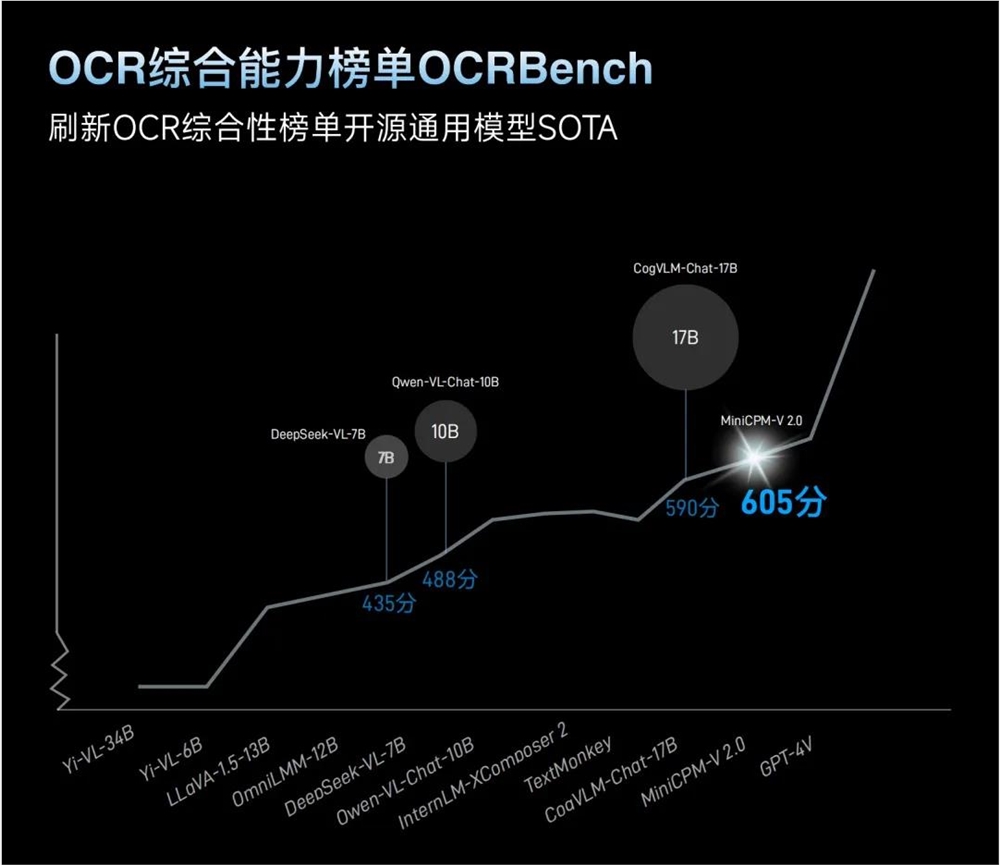

其次再看OCR综合能力(光学字符识别),这可以说是检测多模态识别和推理能力最核心的指标。

在权威OCR综合能⼒OCRBench列表,MiniCPM-V2.0也以2B的“姿势”竞争刷新了开源模型SOTA:

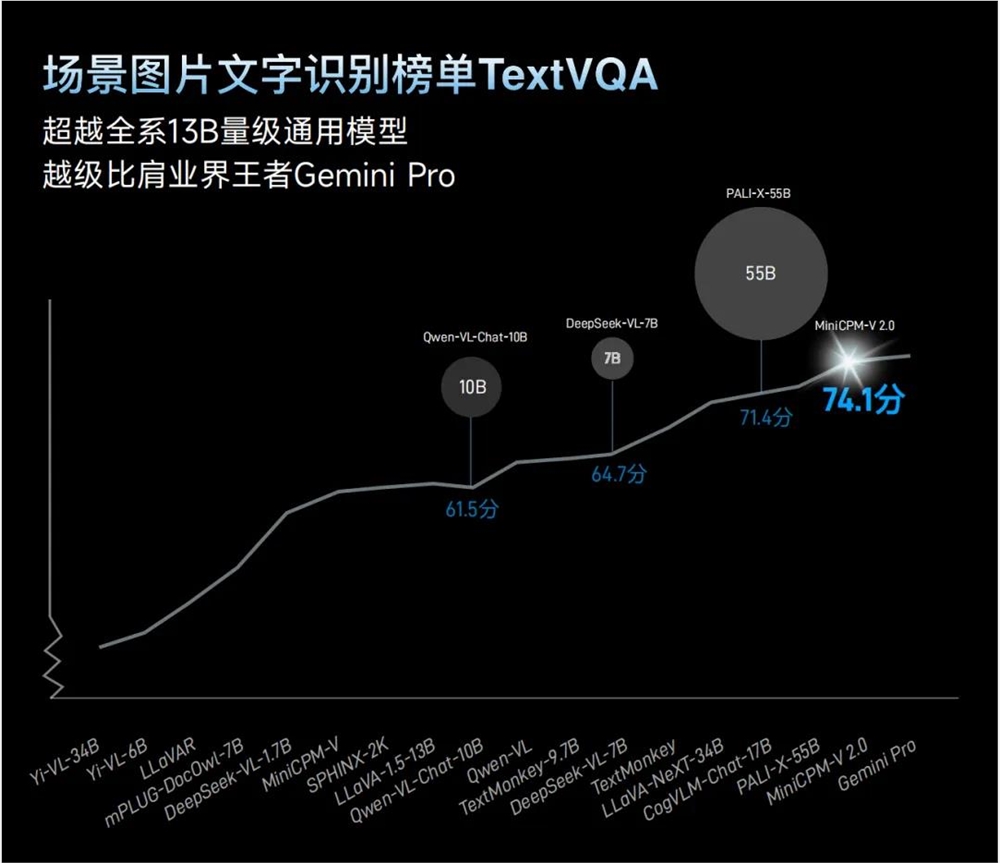

而且在场景图片文字识别列表TextvQA中,MiniCPM-V2.0更是直接秒杀全系列13B体积的通用模型。

甚至有些能力可以与多模态领域相媲美王者Gemini Pro:

不仅如此,在中文OCR能力方面,MiniCPM-V2.0的性能效果明显超过GPT-4V。

识别街景图也是如此,MiniCPM-V2.建筑的名字可以准确地叫出来,但GPT-4V只能回答“看不清楚”。

那么,MiniCPM-V2.怎样才能做到不“近视”?

制作OCR的传统方法比较粗糙:它们只能处理固定尺寸的图片,因此会强行压缩过大或不规则的图片。

这将导致原始图片中大量信息的丢失。当它再次被放大时,它就像近视一样。许多细节变成了马赛克:

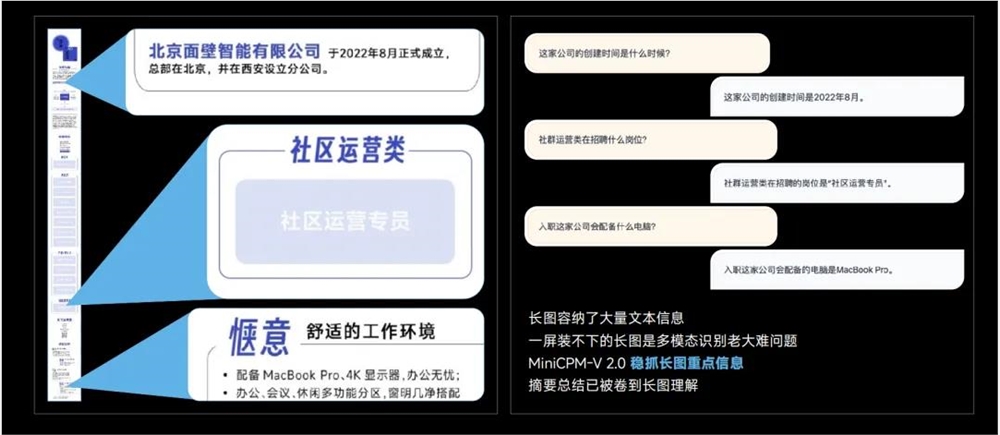

同样,传统的处理方法也是如此。长图的极端长宽比(如1:9)效果会大大降低,因为长图压缩成正方形也会导致大量信息丢失。

为此,面壁智能团队提出的解决方案是“分而治之”——

不是暴力压缩,而是将不规则图片分成几个小图片,然后按照大型OCR的方式进行自适应。

同时,为了解决大图像“切块”后计算量增长的问题,团队还进行了有针对性的视觉模块压缩工作,可以通过局部视觉感知压缩方法进行增长计算。

因此,计算量和模型效果之间的平衡得到了保证。

根据团队介绍,MiniCPM-V2.0可以处理最大180万像素高清大图,甚至180万像素:高清图片9极限宽高比,对其进行高效编码和无损识别。

具体效果如下:

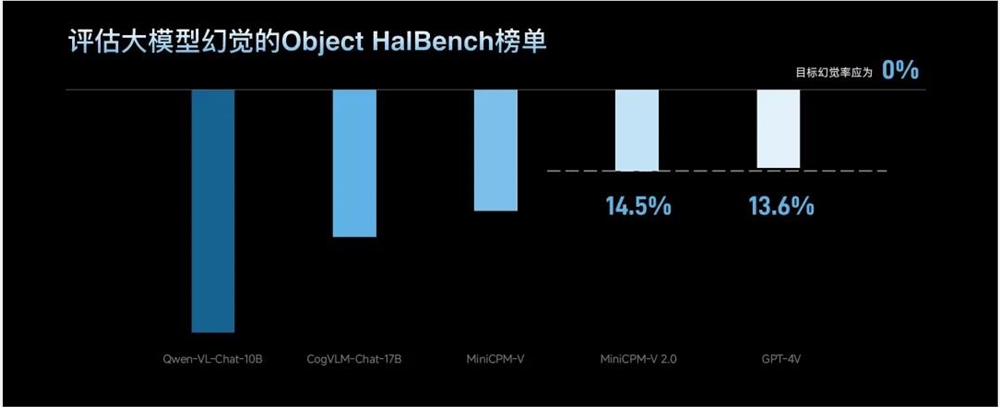

除多模态通用能力和OCR综合能力外,幻觉也是考虑多模态大模型性能的重要指标之一。

在这方面,MiniCPM-V2.Object参与的是Object HalBench列表。

结果表明,其幻觉水平与GPT-4V持平:

MiniCPM-V2.0,也只是智能的面墙最新发布内容的一个角落。

除此之外,面壁智能还发布了三个同样是“小体积”的大模型。

因此,“四大金刚”的阵容在MiniCPM2.0矩阵中形成——四驱小钢炮。

那么四轮驱动小钢炮中其他三个大型模型解锁了什么能力呢?让我们继续往下看。

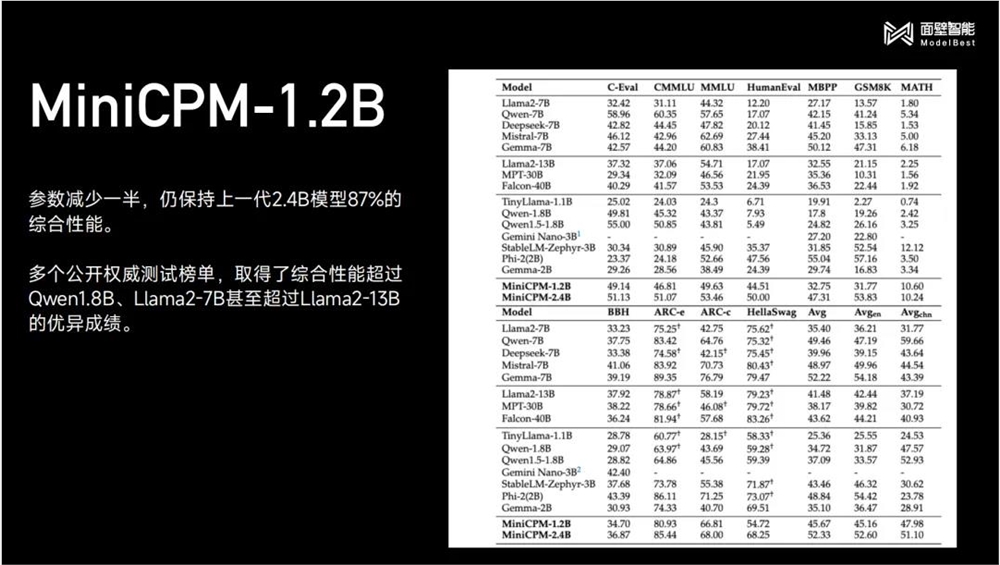

在追求“小”的过程中,面壁智能再次刷新了自己的记录——MiniCPM-1.2B。

至于它的特点,一言以蔽之:

参数减半,仍保持上一代2.4B模型87%的综合性能。

同样,在公开评估名单中,其成绩仍在超越:

值得一提的是,MiniCPM-1.2B现在也可以在手机端侧跑,速度可以达到25tokens/s(人类说话速度的15-25倍):

△现场演示效果

不仅如此,MiniCPM-1.2B还做到了打下价格和内存。

以iOS为例,MiniCPM-2.4B量化模型为2.10G;MiniCPM-1.2B,则只需要1.01G,内存减少51.9%。

就价格而言打了6折:1元=415万tokens。

(计算方法为:苹果A17Pro为130美元(约950元人民币),如开metal,速度快最大25tokens/s;如果芯片使用5年,推理的代价是 (25×3600×24×365×5)/950=415万 tokens/元)

这意味着更多的端侧场景已经成为可能,不仅是手机,还有可穿戴设备,PC、智能家居、汽车等。

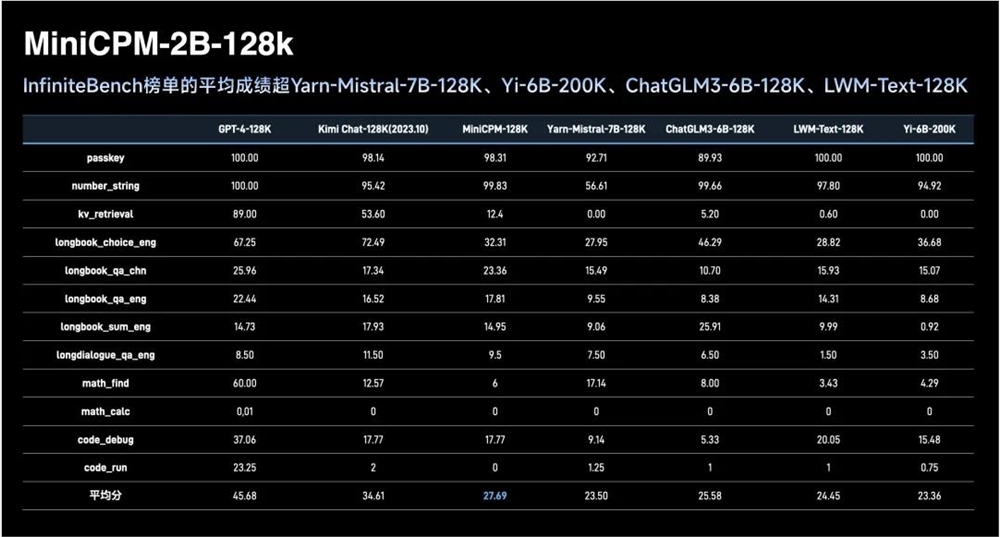

每个大模型的玩家都在你追我长文本领域,面壁智能这次也出手了——MiniCPM-2B-128K。

直接解锁一个新的——最小的128K长文本大模型。

InfiniteBench榜单的平均成绩也超过了其他同体量的选手:

我们之所以要做这项工作,是因为当我们真正需要调用长文本和大模型时,我们仍然需要非常大的内存来做更好的推理工作。

面壁智能表示,他们将继续优化MiniCPM-2B-128K,使其能够尽快在端侧运行。

此外,面壁智能还在另一场火灾技术上发力,那就是MoE(混合专家)——发布了MiniCPM-MoE-8x2B模型。

(MoE可以在不增加推理成本的情况下激增大模型的性能。)

2B小钢炮(MiniCPM1,通过MoE性能增强.0)在原有的基础上,平均性能提高4.5个百分点。

从列表结果来看,MiniCPM-MoE-8x2B模型超越了性能,推理成本仅为Gemma-7B的69.7%:

以上是四轮驱动小钢炮的全部内容。

不难看出,四轮驱动小钢炮中的每一个“驱动力”都是主要的“够小,但能打”。

而且纵观面壁智能的发布,最常提到的两个关键词是“端侧”和“最小”。

那么为什么面壁智能如此呢?极致在这里追求地面?

事实上,从大模型的整体发展趋势来看,这两个关键词早已定数。

自从ChatGPT引爆大模型以来,首先在国内外引发了百模大战的热潮,将大量的计算能力和资金投入到训练过程中。

底座大模型训练完成后,各大模型玩家将工作重心转向推理侧,随后迎来了各种AIGC应用的百花齐放。

同时,大型模型不再仅仅是比较参数规模、跑分和评价,更注重在应用方面的努力。

总之,比较就是看谁能“快好省”地用起来。

在端侧的表现尤为明显,如人工智能手机的火灾,AI PC是很好的证明;要让大模型在端侧丝滑运行,其体积注定不要太大。

这注定了端侧的大模型必须满足两点:性能要小,性能要高效;也不难理解为什么面壁智能这么智能极致在这里追求。

然后下一个问题是:怎么做?

面壁智能首席执行官李大海给出了一种“高效公式”解法:

高效大模型=高效训练+高效落地+高效推理

首先在高效训练在这件事上,从面壁智能first 从day开始,已经是一个人了终极同样的目标存在。

当面壁智能第一次训练大模型时,没有多机多卡的训练框架。因此,团队独立开发了BMTrain框架来支持大模型训练,成本直接比GPT-3下降了90%。

如今,面壁智能在高效训练中不断死亡的目标之一就是“高效Scaling” Law”,这也是“第一同样存在的性原理。

它不同于OpenAI向上大力出奇迹的玩法,主要是争取更大的模型压缩效率,用更少的高质量数据训练更好更小的模型,这也是避免巨大浪费计算能力和其他资源的方法之一。

其次是高效落地,具体来说就是AI智能体(Agent)。

早在去年3月,面壁智能就发表了关于AI智能体的相关论文,然后演变成SaaS级智能软件开发平台ChatDev,再次打下这个“一句话开发”的门槛。

具体来说,在产品版ChatDev的支持下,在整个开发过程中,从产品经理到程序员,再到设计和测试,都是人工智能智能体;开发的迭代已经成为一件有想法的事情。

要知道,常规软件的开发周期是2-3周,成本在1万到5万美元之间(包括人力);相比之下,真的是大写的“降本增效”!

此外,基于其大模型底座的基本能力,面壁智能还开源了两项重磅工作——Agentverse和XAgent;再加上我们刚才提到的ChatDev,三者共同形成了大模型驱动的AI Agent“三驾马车”,人工智能智能体是围绕的核心。

这就是为什么人工智能智能体能够有效地实现这一点的原因。

在这里,面壁智能只是在高效训练和高效落地方面形成的“大模型+AI智能体”这样的技术路线。

不久前,AI大牛吴恩达也在X中公开表达了自己的观点,并对这种模式给予了高度认可。

至于高效大模型的最后一部分高效推理,则是端云协同技术。李大海对此表示:

在制作了一个更小的大模型之后,我们仍然不够,我们也希望通过端和云的协调,使所有的大模型应用程序都能实现更低的推理成本。

在这方面,面壁智能早已被涉猎,提出了冠尾蛇投机采样技术可以说打破了传统的云侧大模型服务方案 token 每次生成带来的频繁访问和存储,导致的读写速度瓶颈远低于计算上限。

具体到端与云的合作是将起草的小模型放在手机侧,效果更好的大模型放在云侧。通过使用小模型为大模型起草草稿和验证,减少云访问、存储和写作,减轻云负担。

这样,通过敏捷的双向反馈机制,大小模型可以相互激发推理速度的提高。

以上是智能面墙“高效公式”了。

综上所述,面壁智能到目前为止所做的一切,也与之相反智周万物愿景高度契合——就是要让大模型“快好省”使用。

近日,面壁智能也迎来了融资的好消息——

完成新一轮数亿元融资。

李大海还在公开信中透露了资金的使用情况,仍将是技术和人才:

我们将进一步加快团队建设,提高大模型领域面壁智能的技术实力和市场竞争力。

特别是,我们将重点引进更多优秀人才,加强大模型发展的基本计算能力和数据基础,继续引领「高效大模型」推动大模型高效快速应用落地。

有技术,有人才,有市场,面墙智能是一波值得关注的大模型实力选手。

MiniCPM-V2.0的地址:

https://github.com/OpenBMB/MiniCPM-V

MiniCPM系列地址:

https://github.com/OpenBMB/MiniCPM

Copyright © 2013-2025 bacaiyun.com. All Rights Reserved. 八彩云 版权所有 八彩云(北京)网络科技有限公司 京ICP备2023023517号

本站文章全部采集于互联网,如涉及版权问题请联系我们删除.联系QQ:888798,本站域名代理为阿里云