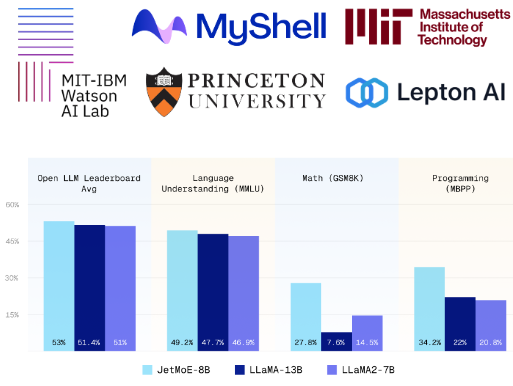

站长之家(ChinaZ.com)4月17日 消息:JetMoE-8B人工智能模型采用稀疏的激活架构,性能优异,训练成本不到10万美元。令人惊讶的是,它的性能甚至超过了LLAMA2-7B、LLaMA-13B和DeepseekMoE-16B。

JetMoE-8B由24个块组成,每个块包含两个MoE层:注意力混合(MoA)与MLP专家混合(MoE)。每个MoA和MoE层有8个专家,每个输入令牌激活2个专家。这种独特的设计显著降低了计算成本,而不牺牲性能。

值得一提的是,JetMoE-8B的总参数虽然达到了80亿,但由于其特殊的结构设计,每个输入令牌只激活了约22亿的参数,大大降低了整体计算需求。

此外,JetMoE-8B的训练完全依赖于公共数据,整个训练过程,包括代码,完全开源,这无疑为人工智能领域的研究和应用提供了极大的便利。

与Open在一起 在LLM排名相同的评估方法下,JetMoE-8B的性能优于LLAMA2-7B、LLaMA-13B和Deepseekmoe-16B,这无疑是其高效性能的结果最好证明。

与此同时,与具有类似训练和推理计算的模型(如Gemma-2B)相比,JetMoE-8B显示出更好的表现。这不仅证明了它在性能上的优势,也显示了它在成本效益上的显著优势。

模型地址:https://huggingface.co/jetmoe/jetmoe-8b

Copyright © 2013-2025 bacaiyun.com. All Rights Reserved. 八彩云 版权所有 八彩云(北京)网络科技有限公司 京ICP备2023023517号

本站文章全部采集于互联网,如涉及版权问题请联系我们删除.联系QQ:888798,本站域名代理为阿里云