站长之家(ChinaZ.com)4月17日 消息:MiniMax 2024年4月17日推出 abab6.5系列模型,这是万亿 MoE(Mixture of Experts)模型。在 MoE 还没有成为行业共识,MiniMax 在研究上投入了大量的精力 MoE 技术,并于今年1月在中国发布首个基于 MoE 架构的 abab6模型。经过三个月的研发,他们推出了更强大的模型 abab6.5模型。

abab6.5系列包括两个模型:abab6.5和 abab6.5.abab6.5拥有万亿参数,支持200k tokens 上下文长度;和 abab6.5s 采用相同的训练技术和数据,但更有效,支持200k tokens 上下文长度,1秒内可处理近3万字的文本。

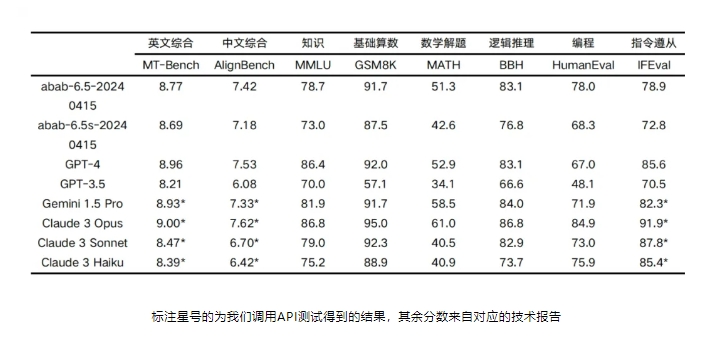

abab6在各种核心能力测试中.5开始接近世界上最领先的大语言模型,比如 GPT-4、Claude-3、Gemini-1.5等。

abab6.5和 abab6.5s 将陆续更新到 MiniMax 其产品包括海螺的生产力产品 AI 和 MiniMax 开放平台。用户可以通过这些产品体验这些先进的语言模型。

Copyright © 2013-2025 bacaiyun.com. All Rights Reserved. 八彩云 版权所有 八彩云(北京)网络科技有限公司 京ICP备2023023517号

本站文章全部采集于互联网,如涉及版权问题请联系我们删除.联系QQ:888798,本站域名代理为阿里云