4月20日消息,近日,MetaMeta推出了80亿和700亿参数 Llama 3开源大模型。该模型引入了新功能和更多的模型尺寸,如改进推理,并使用了新的标记器(Tokenizer),旨在提高编码语言效率,提高编码语言效率模型性能。

英特尔在模型发布的第一时间验证了Llama 3能够在包括英特尔最强处理器在丰富的人工智能产品组合中运行,并披露了即将发布的英特尔至强6性能核处理器(代号为Granite Rapids)针对Meta Llama 3模型的推理性能。

英特尔到强处理器可以满足端到端人工智能工作负载的严格要求。以第五代到强处理器为例,每个核心都内置了AMX加速发动机,它可以提供出色的人工智能推理和训练性能。到目前为止,该处理器已被许多主流云服务提供商采用。此外,强处理器可以提供更低的延迟,同时处理各种工作负载。

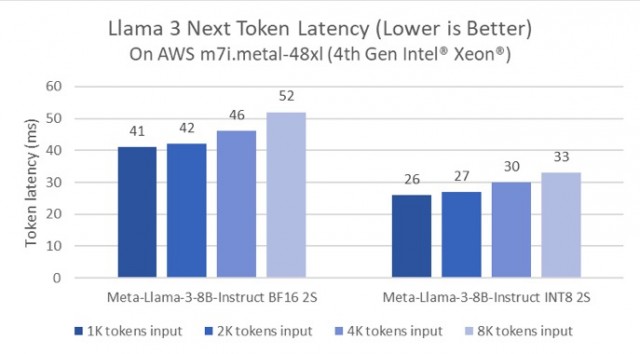

事实上,英特尔一直在不断优化强大平台的大模型推理性能。例如,与Llama相比, Pytorch和英特尔Pytorch扩展包(IntelExtension for PyTorch)延迟减少了5倍。这种优化是通过Paged进行的 Attention算法与张量并行实现,因为它可以最大限度地发挥可用算力和内存带宽。下图显示了80亿参数的Meta Lama 3模型在AWS m7i.metal-根据第四代英特尔到强可扩展处理器,48x实例的推理性能。

Llamama 下一个Token延迟3

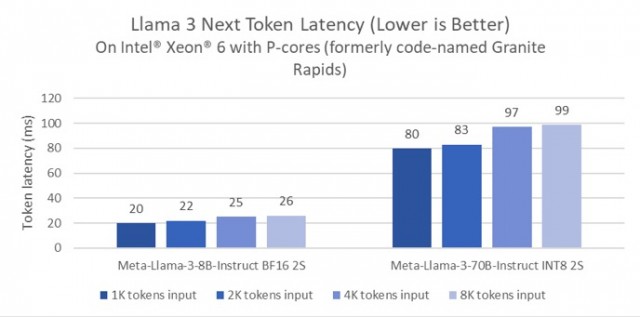

不仅如此,英特尔还首次披露了即将到来的产品——英特尔至强6性能核处理器(Granite) Rapids)针对Meta Llama 3.性能测试。结果表明,与第四代到强处理器相比,英特尔到强6处理器在80亿参数的Llama 3推理模型的延迟减少了2倍,可以在单个双路延迟不到100毫秒的token服务器Llama上运行,如700亿参数 这种更大参数的推理模型。

基于英特尔的实力 6性能核处理器(Granitee代码) Rapids)Llama 下一个Token延迟

考虑到Llama 3具有更高效的编码语言标记器(Tokenizer),随机选择的prompt用于Llama 三、Llama 2.快速比较。当prompt相同时,Llama 与Lama相比,标记3的token数量为Lama 2减少18%。因此,即使是80亿参数的Llama Llama3模型比70亿参数的Llama AWS模型参数较高, m7i.metal-BF16推理在48xl实例中运行时,整个prompt的推理延迟几乎相同(在评估中,Llama 3比Llama好 2快1.04倍)。

Copyright © 2013-2025 bacaiyun.com. All Rights Reserved. 八彩云 版权所有 八彩云(北京)网络科技有限公司 京ICP备2023023517号

本站文章全部采集于互联网,如涉及版权问题请联系我们删除.联系QQ:888798,本站域名代理为阿里云